حتى وقت قريب لم يكن هناك قلق كبير من استخدام تقنيات التزييف العميق في مكالمات الفيديو التي تستخدم البث المباشر لكن مع تطور تقنيات الذكاء الاصطناعي يبدو أن هذا الوضع في طريقه للتغير.

في يونيو من هذا العام ، تم خداع العديد من رؤساء البلديات الأوروبيين بمكالمة فيديو مزيفة من شخص ادعى أنه فيتالي كليتشكو عمدة كييف وقام بتزييف صورته باستخدام تقنية التزييف العميق . كما حذر مكتب التحقيقات الفدرالي من أن المحتالين يستخدمون تقنية التزييف العميق في المقابلات للوظائف البعيدة تمامًا التي توفر الوصول إلى معلومات قيمة.

حيلة بسيطة تكشف التزييف العميق في مكالمات الفيديو

لحسن الحظ اكتشف الباحثون طريقة بسيطة بشكل مدهش للكشف عن مكالمات الفيديو المزيفة التي تستخدم التزييف العميق، فقط اطلب من المشتبه فيه أن يستدير جانبًا !

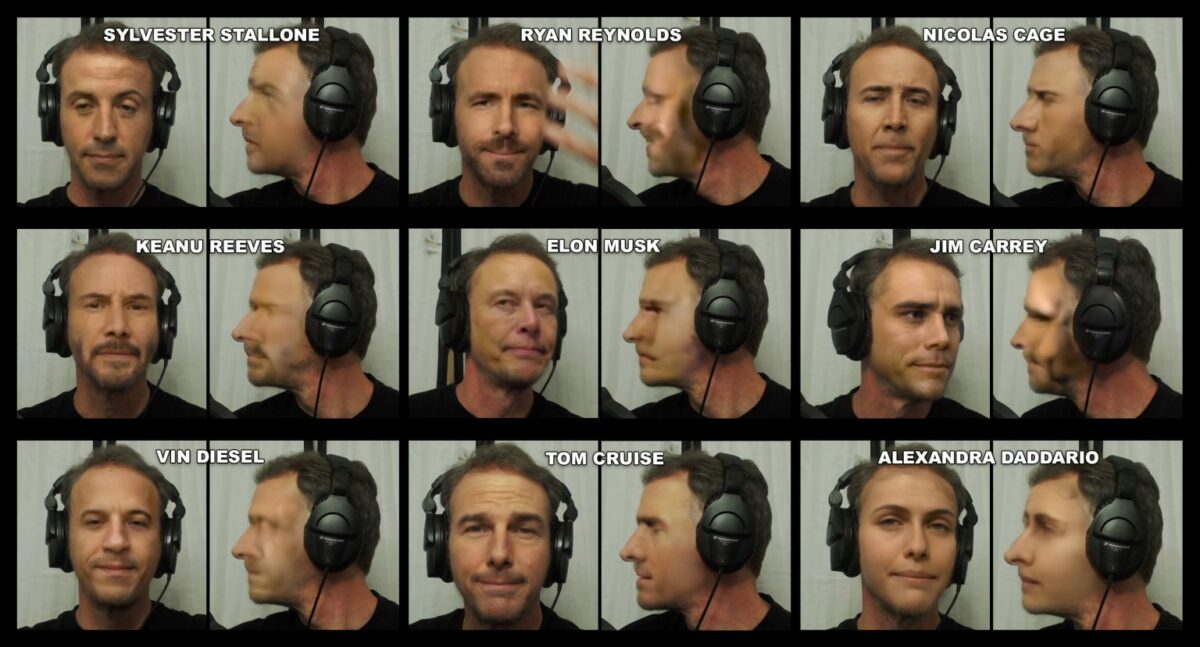

تمت مشاركة الحيلة هذا الأسبوع من قبل Metaphysic.ai ، وهي شركة ناشئة مقرها لندن ، استخدمت الشركة DeepFaceLive ، وهو تطبيق شائع للفيديو العميق ، لتحويل وجه متطوع إلى أشكال مشاهير مختلفين.

كانت معظم اللقطات المزيفة متقنة بشكل يثير الإعجاب عندما كان المتطوع يواجه الشاشة مباشرة. ولكن مع ادارة وجهه بزاوية 90 درجة كاملة ، أصبحت الصور مشوهة وكسرت التعويذة.

يعتقد الفريق أن العيوب تظهر لأن البرنامج يستخدم نقاطًا مرجعية أقل لتقدير المشاهد الجانبية للوجوه. هذا يجبر الخوارزمية على تخمين كيف يبدو الوجه من الجانب . وبالنظر لكون الوجه يكون مخفياً بنسبة 50% يعيق هذا عملية التعرف وبالتالي يفشل البرنامج في بناء الصورة بشكل سليم .

من النادر الحصول على صور جانبية للأشخاص إلا في حالات قليلة مثل الصور التي تلتقط إذا كان الشخص رهن الاعتقال. هذا يجعل من بناء صورة بشكل سليم أمراً صعباً ويتطلب خبرات احترافية عالية.

يظهر بحث Metaphysic.ai وسط مخاوف متزايدة بشأن مكالمات الفيديو العميقة. ربما لن تنقذ هذه الحيلة الجانبية جميع الضحايا في المستقبل حيث سيسعى مقدمي تقنيات التزييف العميق لتلافي المشكلة مستقبلاً ومع ذلك ، فإن خدعة الرؤية الجانبية تضيف فرصة جديدة للكشف عن المزيفين – وربما سبباً آخر لعدم التعرض للاعتقال!

https://metaphysic.ai/to-uncover-a-deepfake-video-call-ask-the-caller-to-turn-sideways/

اترك تعليقاً